Services

Blog

Thèmes

Notre newsletter

Thank you! Your submission has been received!

Oops! Something went wrong while submitting the form.

Depuis juin 2025, Cloudflare a subi trois pannes majeures : le 12 juin, le 18 novembre puis le 5 décembre. Trois incidents, trois causes techniques différentes… mais un même problème de fond : des changements internes mal maîtrisés, propagés à l’échelle du réseau mondial, qui ont temporairement mis à l’arrêt une partie significative d’Internet.

TL;DR spécial Webflow

Webflow migre progressivement son infrastructure d’hébergement vers Cloudflare.

Quand Cloudflare tombe, vos sites restent en ligne côté Webflow, mais la couche réseau / sécurité qui les expose au monde

renvoie des erreurs 5xx. Aux yeux de vos visiteurs, c’est donc votre site qui est “en panne”, même si le bug vient

de l’infrastructure sous-jacente.

Le 12 juin, Cloudflare rencontre un incident d’environ 2 h 30 qui touche plusieurs briques clés : Workers KV (stockage distribué), Access, WARP, Gateway, mais aussi des services comme Images, Stream, Workers AI et le dashboard.

Pour un site Webflow, ce type de panne se traduit surtout par :

Le 18 novembre, Cloudflare subit sa pire panne depuis 2019. Un fichier de configuration utilisé par la brique Bot Management (filtrage des bots / trafic automatisé) est mal généré et mal validé avant d’être poussé sur le réseau mondial.

Vu de vos clients, c’est “Internet qui rame” ou “votre site qui ne marche plus”. Vu de vous, studio Webflow, c’est surtout un problème de :

Le 5 décembre, nouvelle panne, plus courte mais spectaculaire.

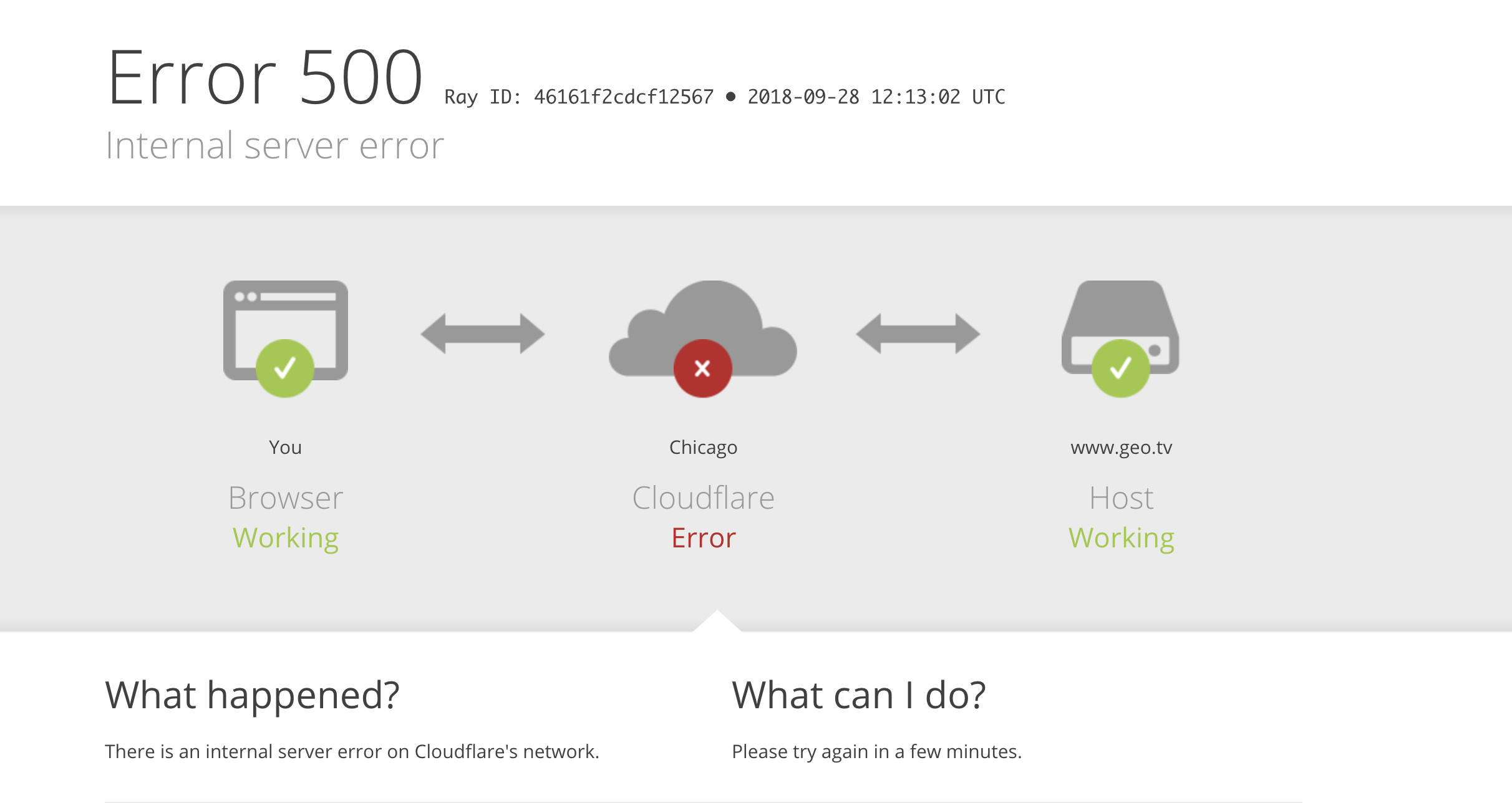

À 08:47 UTC, une mise à jour de configuration liée à des règles de sécurité fait échouer une partie des requêtes,

provoquant des 500 Internal Server Error pour environ 28 % du trafic HTTP traité par Cloudflare.

L’incident est résolu vers 09:12 UTC.

Contexte : Cloudflare déploie en urgence des protections contre une vulnérabilité critique dans l’écosystème React / Next.js (CVE-2025-55182, parfois surnommée “React2Shell”). Pour inspecter correctement les requêtes potentielles, ils augmentent la taille de certains buffers de lecture dans le WAF et désactivent un outil de test interne via un killswitch.

Problème : un bug dormant dans le code se déclenche lors de cette désactivation et provoque une erreur interne

dans une partie du proxy Cloudflare. Résultat : les requêtes tombent en 500 pour une partie des clients,

dont LinkedIn, Zoom, Canva, Shopify, GitLab, Fortnite et d’autres services très visibles.

À retenir pour la suite

Juin, novembre, décembre : des pannes de nature différente (stockage KV, gestion des bots, patch de sécurité React),

mais un même schéma : un changement interne mal encadré, répliqué trop vite et trop largement,

avec des garde-fous (tests, rollout progressif, rollback) insuffisants au moment T.

Depuis 2025, Webflow migre progressivement son hébergement vers Cloudflare : nouveaux DNS, nouvelles IP, nouvelle couche CDN / proxy, etc. Concrètement, cela signifie que :

Comment l’expliquer simplement à un client

« Votre site est construit et hébergé sur Webflow. Webflow s’appuie sur Cloudflare pour la partie “routeur d’Internet”

(réseau + sécurité). Quand Cloudflare a un incident, cela peut faire apparaître des erreurs 5xx chez vos visiteurs,

même si le site lui-même n’a aucun bug. »

Cloudflare est conçu avec une logique de sécurité fail-closed : si les données de configuration ou de contrôle (politiques, identités, règles) ne peuvent pas être lues, la requête est bloquée plutôt que laissée passer. C’est logique pour protéger les clients… mais cela signifie qu’un incident sur une base de données ou une config peut rapidement se transformer en coupure visible à grande échelle.

Dans les trois cas, on retrouve le même problème de fond :

Cloudflare annonce vouloir renforcer :

Au-delà de la technique, il y a un enjeu de modèle : une part croissante du Web dépend de quelques grands acteurs d’infrastructure (Cloudflare, AWS, Google Cloud, etc.). Quand l’un d’eux vacille, ce n’est pas “un site” mais des millions qui sont touchés.

Pour une agence Webflow

Votre risque ne se limite plus à “est-ce que mon CMS est stable ?”.

Vous êtes embarqués dans un risque systémique : la disponibilité de vos livrables dépend d’un enchaînement

Webflow → Cloudflare → fournisseurs cloud. Même avec un travail irréprochable côté design et développement, vous héritez du profil

de risque de cette chaîne.

1. Être transparent sans dramatiser

Expliquez que les pannes récentes viennent de l’infrastructure globale Cloudflare, utilisée par Webflow et par une grande partie des grands sites mondiaux, et non d’une erreur de développement sur leur site. Votre rôle : traduire l’incident sans jargon, et montrer que vous suivez la situation.

2. Rassurer sur la sécurité

La panne du 5 décembre, par exemple, vient d’une mise à jour de sécurité destinée à protéger contre une faille critique. Le problème n’est pas un piratage de leur site, mais la façon dont cette mise à jour a été déployée à l’échelle du réseau. Vous pouvez insister sur le fait qu’aucune donnée de leur site n’a été compromise.

3. Poser des garde-fous réalistes

Pour les clients à forte criticité (SaaS, B2B, e-commerce), vous pouvez proposer :

Concrètement, pour votre agence

Pour aller plus loin

Comment rédiger un SLA honnête quand votre site dépend de Webflow + Cloudflare